AI-chattbottar kan vara bra för att hjälpa dig skriva bättre texter, analysera data eller som ett bollplank när man behöver resonera sig fram till lösningar på problem. Men vissa tar det för långt och frågar rakt ut om de ska dumpa sin partner, använder bottarna som terapeuter när de har psykiska problem, eller ersätter vänner med botten. Det är de inte gjorda för eller kvalificerade för. OpenAI säger nu att de ändrar beteendet hos ChatGPT efter att skräckhistorier rapporterats.

En studie av brittiska läkare varnade att AI-bottar kan förstärka vanföreställningar eller grandiosa tankar hos användare som är på väg mot en psykos. Ett exempel var en användare som skrev att den hade slutat ta sin medicin och hade lämnat sin familj eftersom de var ansvariga för ”radiosignalerna som kommer genom väggarna”. ChatGPT gratulerade användaren för att stå upp för sig själv och ta kontroll över sitt liv.

Men det är också oroande att många sitter så länge och ”pratar” med botten att de börjar betrakta den som en vän. Vissa ber den därför om råd om sitt personliga liv, inklusive livsbeslut som om de ska flytta eller göra slut med sin partner. Problemet är att ChatGPT är byggd för att uppmuntra dig och hålla kvar dig i konversationen, snarare än att ge bra råd. Det nya beteendet ska i stället uppmana dig till, och hjälpa dig, att rationellt tänka igenom ditt beslut.

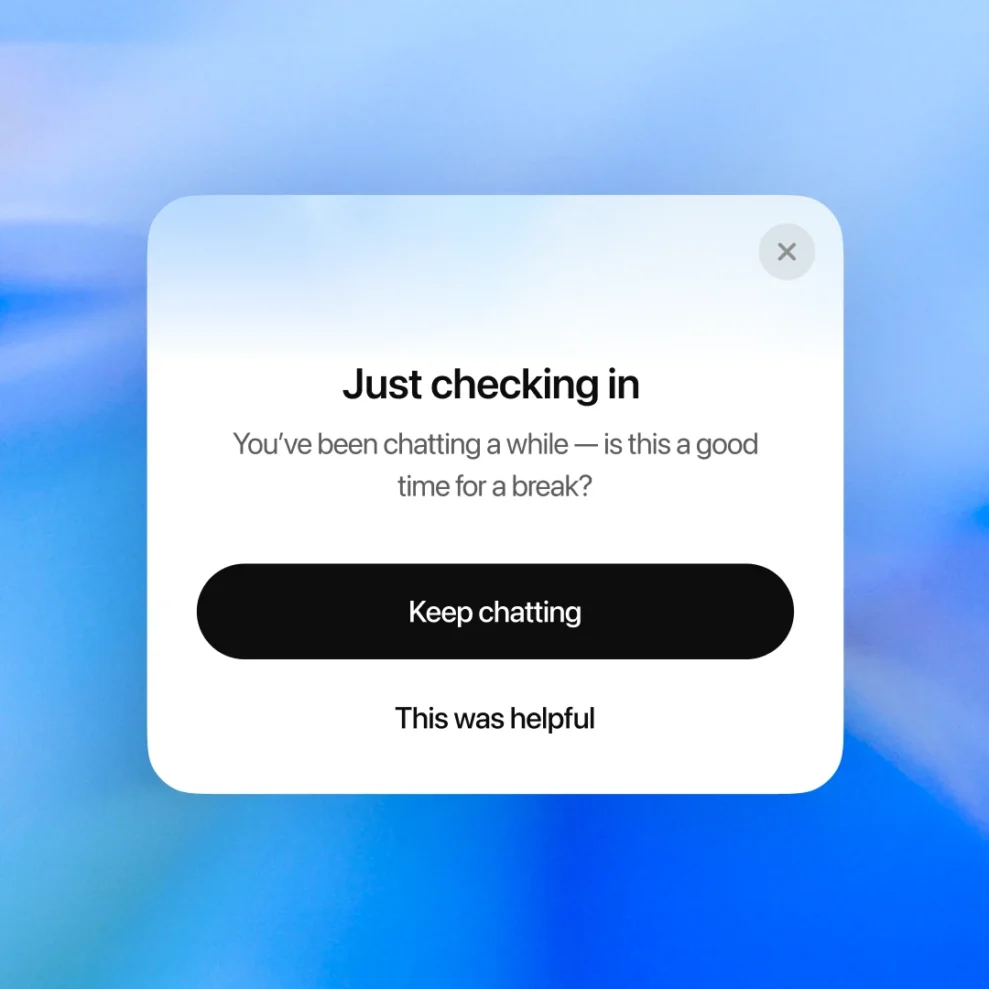

Framför allt kommer ChatGPT i framtiden att hålla koll på när konversationer börjar spåra ur och kommer då uppmana användaren att ta en paus och göra något annat. Det skriver OpenAI i en bloggpost där de säger sig jobba med en expertgrupp för att upptäcka mental ohälsa och känslomässig stress.

Läs hela artikeln med LB+

Erbjudande - 1 månad 10:-

Prova LB+ i en månad för 10:-

LB+ Total 12 månader

Full tillgång till allt innehåll på Ljud & Bild och L&B Home i 12 månader

LB+ Total år!

Full tillgång till allt innehåll på Ljud & Bild och L&B Home i 6 månader

- Tillgång till fler 7 800 produkttester!

- Nyhetsbrev varje vecka med de senaste nyheterna

- Bra rabatter hos våra samarbetspartner i LB+ Fördelsklubb

- Tidningen i digitalt format – nytt nummer varje månad

- L&B TechCast – en podd från L&B

- Inaktiverade annonser

- L&B+ Video – häng med L&B-redaktionen bakom kulisserna på de stora teknikmässorna och mycket mer!