Enligt studien misslyckas så kallade ”simulated reasoning models” som OpenAI:s o1 och o3, DeepSeek-R1 och Claude 3.7 Sonnet Thinking med problem som kräver systematiskt tänkande. De producerar resultat som inte är bättre än om man bara letar efter tidigare svar på problemet i deras träningsdata. Vilket är vad traditionella stora språkmodeller gör. Studien som går under namnet ”The illusion of thinking” kommer fram till ett liknande resultat som en annan nyligen publicerad studie från USA Mathematical Olympiad.

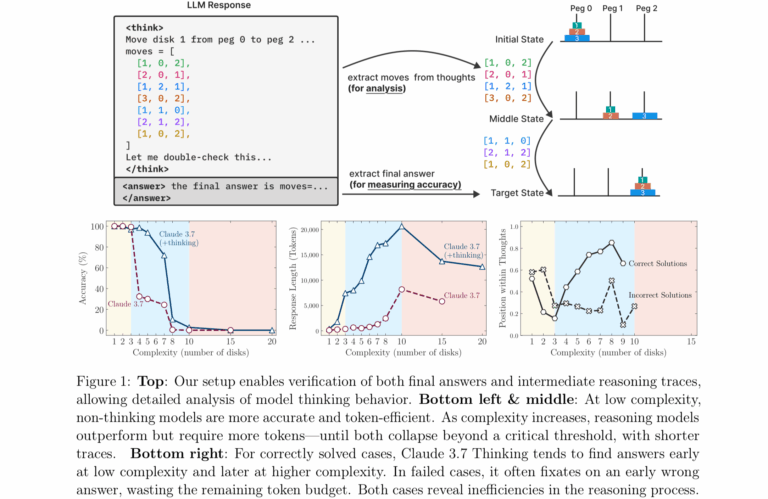

Forskarna undersökte så kallade Large Reasoning Models som försöker simulera en logisk resonerande process genom att bryta ner komplexa problem till enklare och lösa dem steg för steg.

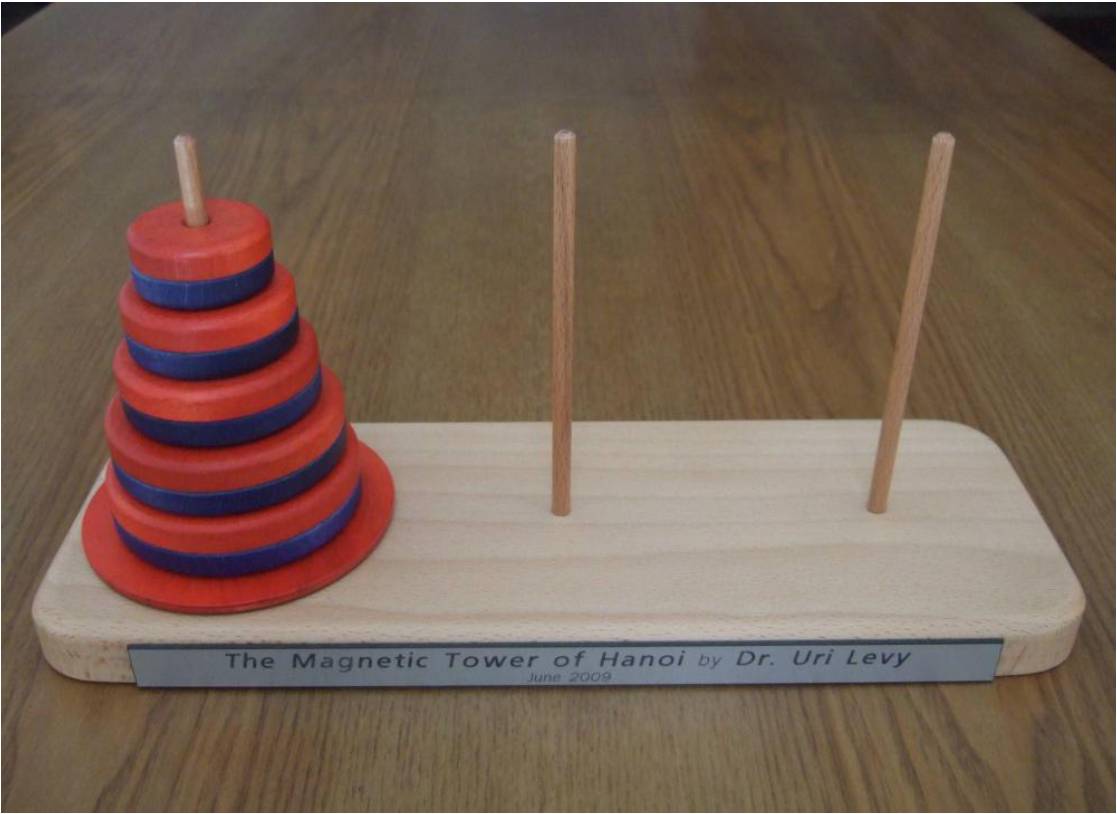

Undersökningen bestod av att utsätta AI-modellerna för klassiska tankepussel som Tower of Hanoi, spela Checkers (dam), tankenöten med att korsa en flod och Blocks World. Man började med nybörjarnivå och stegade upp svårighetsnivån till extremt svår. Exempelvis kräver en 20-ringars Tower of Hanoi över en miljon drag.

Resultatet var att de endast klarade att visa en lösning i under 5 procent av fallen, och endast en lyckades nå 25 procent. Ingen av dem lyckades visa en perfekt lösning trots 200 försök. Detta trots att AI-forskaren Herb Simon visade en lösning på Tower of Hanoi redan 1957, och det finns gott om färdiga algoritmer för lösningen på nätet. Inte ens när forskarna försåg modellerna med algoritmen förbättrades resultatet. Något som en forskare menade innebar att ”deras process inte är logisk och intelligent”.

Forskarna menar att problemet med dagens utvärderingar av resonerande modeller är att de endast bryr som om ifall resultatet blir korrekt. Om svaret fanns i deras träningsdata är irrelevant, så ingen ifrågasätter om de verkligen resonerade sig fram eller bara kopierade svaret.

Det ska sägas att studien kommer från Apples forskare, det enda stora techföretaget som inte lanserat en egen AI-lösning. Den har också fått kritik då andra forskare påpekar att dagens modeller är byggda för att inte lägga för mycket tid på ett problem. Kan de inte lösa det snabbt så gissar de. Apples forskare säger också själva att ”tankenötter är ett smalt område och kanske inte är representativt för problemlösning i allmänhet”, och varnar för att extrapolera resultatet och dra för långtgående slutsatser.

Med det sagt fick ChatGPT 4o stryk av en Atari 2600 spelkonsoll från 1977 när det gällde att spela schack…

Läs studien hos Apple Research

Läs hela artikeln med LB+

Erbjudande - 1 månad 10:-

Prova LB+ i en månad för 10:-

LB+ Total 12 månader

Full tillgång till allt innehåll på Ljud & Bild och L&B Home i 12 månader

LB+ Total år!

Full tillgång till allt innehåll på Ljud & Bild och L&B Home i 6 månader

- Tillgång till fler 7 800 produkttester!

- Nyhetsbrev varje vecka med de senaste nyheterna

- Bra rabatter hos våra samarbetspartner i LB+ Fördelsklubb

- Tidningen i digitalt format – nytt nummer varje månad

- L&B TechCast – en podd från L&B

- Inaktiverade annonser

- L&B+ Video – häng med L&B-redaktionen bakom kulisserna på de stora teknikmässorna och mycket mer!